Fiche mise en ligne le 22 février 2024

Chaque jour ou presque, les médias évoquent la révolution de l’intelligence artificielle (IA) et les nouvelles applications qu’elle autorise, mais il y a plusieurs types d’intelligence artificielle.

Identifier les différentes sortes d’IA

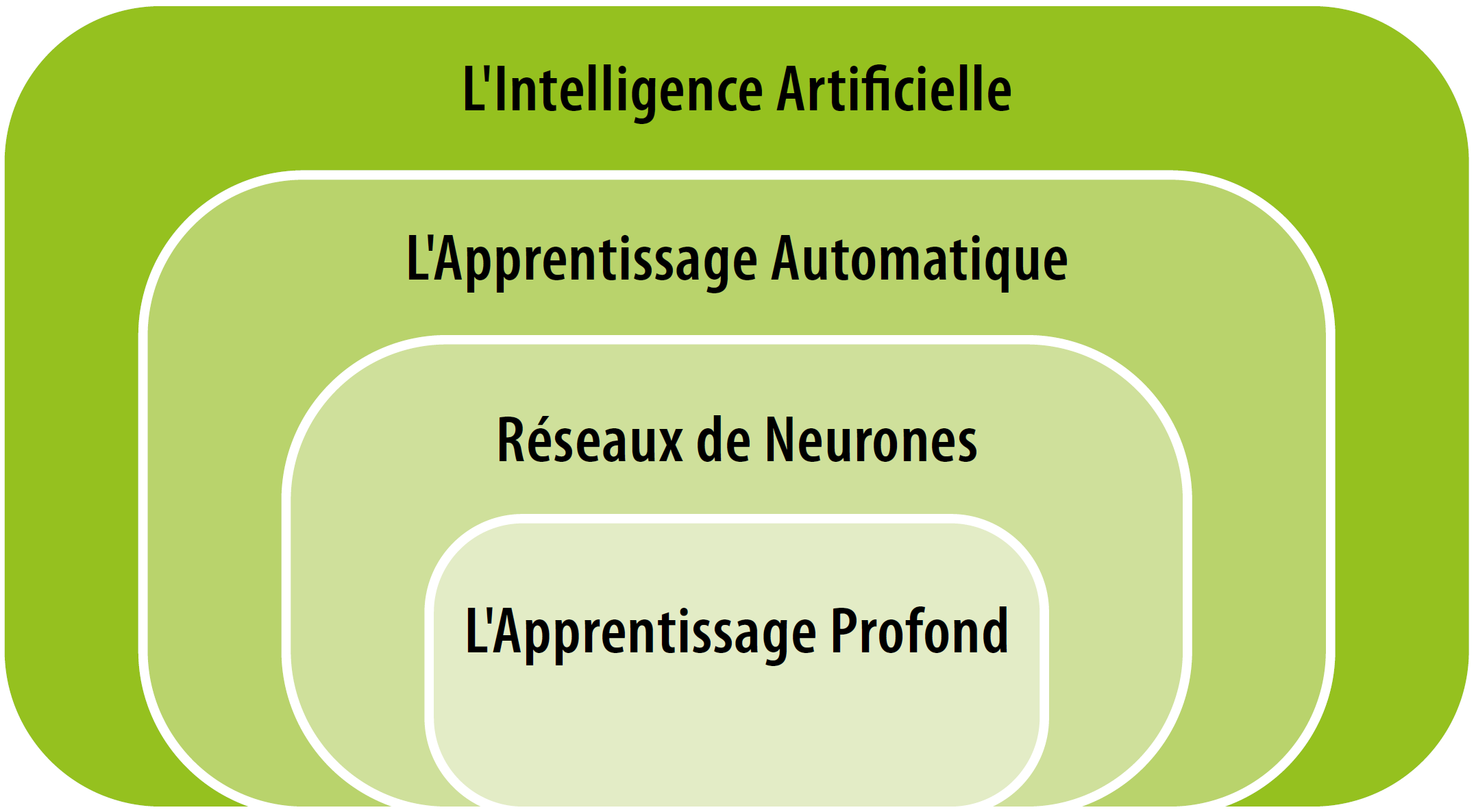

Si l’on parle beaucoup d’intelligence artificielle aujourd’hui, ce terme regroupe en réalité différentes technologies. L’IA prédictive est une sorte d’IA qui apprend à détecter des formes (par exemple des images, de la musique, de la parole/des textes, des vidéos) alors que l’IA générative apprend à les produire (ex : DallE, ChatGPT). On distingue également une autre sorte d’IA désignée sous le terme d’IA symbolique, qui utilise des symboles et des règles de traitement de l’information pour effectuer des tâches (les systèmes experts) qui diffère de l’IA connexionniste, de type réseau de neurones (comme celle utilisée dans ChatGPT), cette dernière étant une programmation inspirée de façon très simplifiée des sciences du cerveau.

La vraie révolution vient de la capacité d’apprentissage des IA, à partir d’énormes corpus de données. Cependant, il existe 3 types d’algorithmes d’apprentissage utilisés par les IA : l’apprentissage dit supervisé où l’humain donne des informations sur ce qui va être appris (en annotant des images), l’apprentissage auto-supervisé (nul besoin d’annotation) et l’apprentissage par renforcement (par essai-erreur). Depuis l’apparition des algorithmes de deep learning (apprentissage profond) en 2005, l’approche connexionniste a fait de très grands progrès dans la reconnaissance d’images et de la parole à partir d’approches d’apprentissage supervisé.

Les meilleurs systèmes actuels d’IA utilisent des réseaux de neurones avec la technologie de transformers proposée par Google Brain en 2017. Par exemple, ChatGPT utilise un modèle de fondation de type transformer (GPT3.5) qui a été obtenu par autoapprentissage, à partir d’un gigantesque corpus. Mais avant sa mise à disposition fin 2021, ChatGPT a été optimisé grâce à des apprentissages supervisés et par renforcement par des humains, de façon à affiner les résultats et à éliminer les propos non souhaitables, voire toxiques. On utilise pour cela le retour d’information humain sur le texte généré comme mesure de la performance, afin d’optimiser le modèle. Cette méthode est appelée apprentissage par renforcement à partir du feedback humain (reinforcement learning from human feedback, ou RLHF).

Comprendre le fonctionnement d’une IA générative

L’IA qui autoapprend a une forme d’« intelligence » très différente de l’intelligence raisonnée des humains. Au départ, l’ingénieur écrit un programme d’entraînement, ensuite le système d’IA s’entraîne tout seul en autoapprentissage. L’IA générative crée un modèle à partir des régularités les plus saillantes de milliards de données d’apprentissage. Récemment, les transformers ont montré des capacités impressionnantes pour créer des modèles qui produisent, à partir d’un prompt (une requête), des textes, images, vidéos ou encore du code informatique imitant les données réelles. Ces IA génératives sont également capables d’émergences de comportements complexes qu’un ingénieur ne saurait pas programmer par des méthodes classiques.

Ce que l’IA ne sait pas encore faire

L’accumulation de données d’apprentissage dans les IA tend à amener des étincelles d’émergence de comportements intelligents du système de génération. Mais les capacités des IA génératives restent instables et varient en fonction du volume des données utilisées pour l’apprentissage, et de l’optimisation des systèmes d’IA. L’enjeu de l’intelligence artificielle est d’établir une approximation des phénomènes sur la base de statistiques, donc non pas ce qui est « vrai » mais ce qui est « très probable ». Cependant, des millions de phrases d’apprentissage proférées par des humains ne donnent pas accès aux idées abstraites ou philosophiques exprimées par le langage humain. L’IA sait généraliser un premier pas vers une certaine intelligence. Les IA savent calculer mais ne peuvent pas encore tout résoudre, et elles n’ont par ailleurs pas d’idées pour parvenir à le faire. L’IA ne sait pas inventer, elle ne sait que reprendre des idées déjà exprimées.

Quand l’IA surpasse l’intelligence humaine…

L’IA possède une acuité non-humaine pour détecter des signaux rétifs à l’œil nu ou inaudibles au champ auditif humain. Ainsi, certains systèmes d’IA permettent de classifier des formes, des images et des sons avec une performance supérieure à celle des humains. Personne ne conteste aujourd’hui que la puissance croissante des IA, combinée à de gigantesques corpus de signaux issus du monde entier, qui seraient ingérables pour notre cerveau, permettra de résoudre des problèmes qui nous dépassent complètement ; en cela l’IA sera plus « intelligente » que les humains dans de nombreuses tâches. Elle peut donc aider les humains à résoudre des problèmes et à être individuellement plus créatifs. Par contre, l’IA aura du mal à expliquer ses prédictions et à préciser le contexte des sources qu’elle a utilisées pour générer ses réponses. Néanmoins, face à des situations inconnues, les humains possèdent d’autres formes d’intelligence, comme une intelligence émotionnelle par exemple, dont l’IA ne connaît pas encore le langage.

Analyser les conséquences des usages de l’IA : entre potentialités et risques

L’expression « intelligence artificielle » (IA) tend des pièges. Elle peut masquer les vrais enjeux et laisser croire à une modélisation de l’intelligence humaine. Le terme d’intelligence artificielle (IA) a ainsi souvent été critiqué. Il est quelque peu provocateur, car l’IA ne « pense » pas au sens humain, elle calcule. Le but de l’invention d’un système d’IA est d’imiter ou de simuler une capacité humaine (peut-être trop pénible pour l’humain) ou de pallier une incapacité humaine : notre cerveau ne peut intégrer tous les signaux du monde et ne peut calculer aussi vite que les machines. L’IA permet, indirectement, de mieux comprendre comment fonctionne notre propre cerveau, ce qu’il sait faire et ce qu’il ne parvient pas à réussir, notamment à cause de biais cognitifs qui peuvent le conduire à des raisonnements erronés.

Aujourd’hui, nous ne sommes encore qu’au début de cette révolution qui bouleverse l’économie cognitive, mais il est certain que l’IA sera de plus en plus « intelligente ». En termes d’enjeux de citoyenneté, il apparaît toutefois nécessaire de parvenir à réguler l’IA par des lois et d’instaurer des normes pour ses usages. En effet, depuis 2021, les concepteurs d’IA ont pris conscience du pouvoir de ce type de technologie, et des risques qu’elle peut engendrer (mésinformation, désinformation, discours ne respectant pas les limites juridiques de la liberté d’expression). De plus, il apparaît également aujourd’hui plus que nécessaire d’éduquer et de former à l’éthique de l’IA à l’École et dans le milieu du travail pour permettre aux citoyens de s’emparer de façon consciente et responsable de cette technologie prometteuse.

Laurence Devillers, professeure à l’université Paris-Sorbonne et chercheuse au Laboratoire d’informatique pour la mécanique et les sciences de l’ingénieur (Limsi) du CNRS

Ressources complémentaires :

DEVILLERS, Laurence. Les robots « émotionnels ». L’observatoire, 11/03/2020. Fondation

Blaise Pascal. Capsules Éthique du numérique pour les enfants.

MASSARON, Luca. MUELLER, John Paul. L'intelligence artificielle pour les Nuls. Pour les nuls, 2022.

SABOURET, Nicolas. DE ASSIS, Lizete. Comprendre l'intelligence artificielle. Ellipes, 2019.

LE CUN, Yann. Quand la machine apprend : La révolution des neurones artificiels et de l'apprentissage profond. Odile Jacob, 2019.